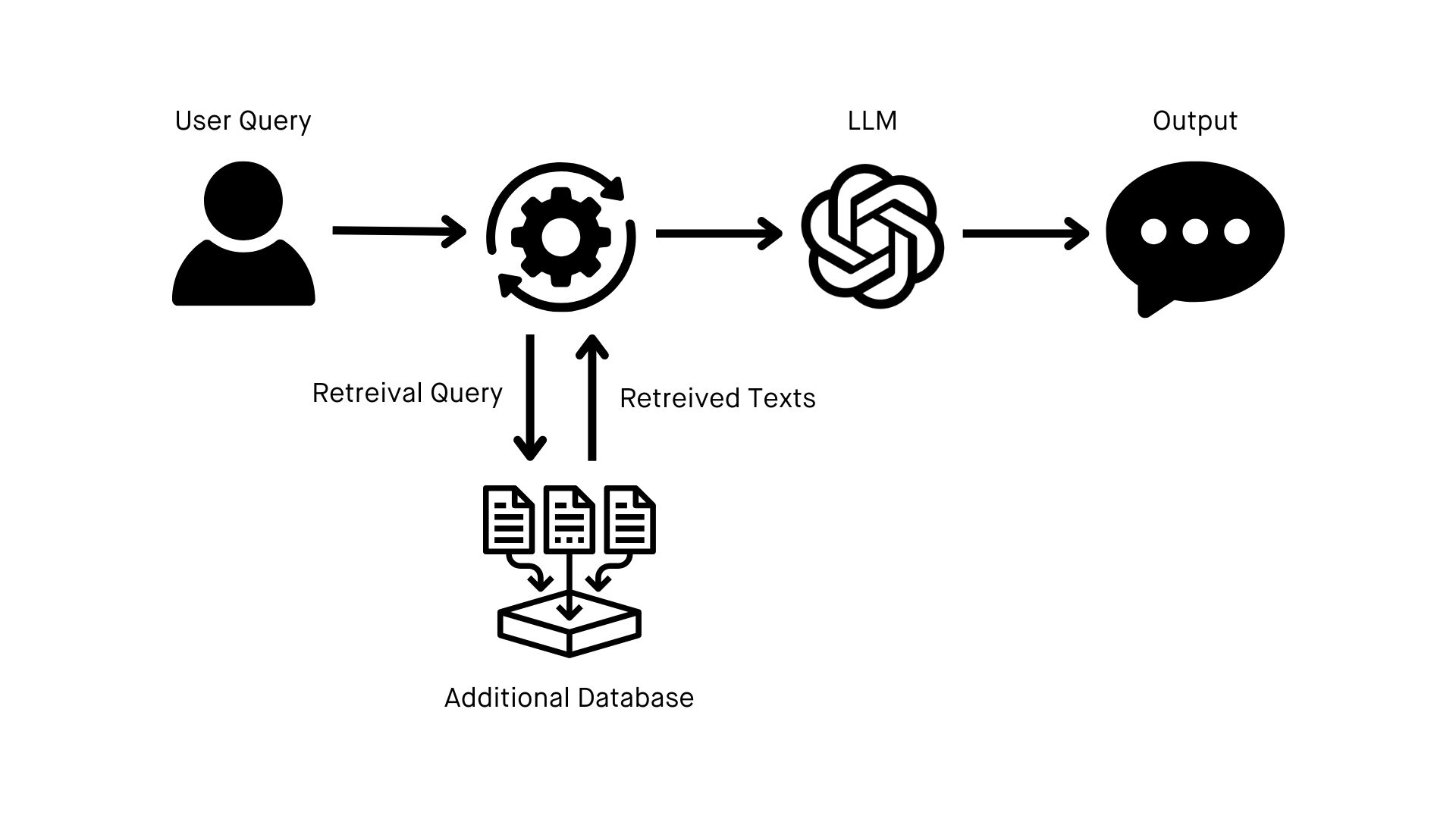

Para comenzar a construir tu propia implementación de RAG, necesitarás los siguientes elementos.

Preparar estos elementos tomará algunos meses, dependiendo de la complejidad de tus datos y el estado actual de tu arquitectura. Sin embargo, la buena noticia es que esta es la parte más laboriosa del proceso. Una vez que tus objetivos y datos estén en orden, la implementación de RAG y las pruebas del sistema toman solo una o dos semanas.

Aún mejor, estos elementos fundamentales no solo son pasos cruciales para RAG, sino que también se aplican prácticamente a todos los demás aspectos de la transformación de IA de tu organización.

Un conjunto de objetivos claramente definidos

Con RAG, cuanto más específicx puedas ser con lo que deseas lograr, mejor. Ya sea mejorar el soporte al cliente, crear contenido personalizado o mejorar la toma de decisiones basada en datos, saber cuándo y cómo interactuarás con el sistema te proporcionará la orientación necesaria durante todo el proceso de implementación.

El LLM correcto

Puede parecer obvio, pero necesitarás seleccionar el LLM que mejor se adapte a tu caso de uso y que pueda integrarse con un sistema de recuperación. Puedes elegir un LLM de código abierto como Mistral o Llama, o una opción comercialmente disponible como ChatGPT.

Algunos factores importantes a considerar en tu decisión son la escalabilidad, las capacidades de integración, el costo y, por supuesto, tu conjunto de objetivos claramente definidos.

Una base en ingeniería de datos

La mejor manera de abordar RAG es considerarlo como un ejercicio de ingeniería de datos. Dado el estado actual de la IA, con la mayoría de las organizaciones en las primeras etapas de su transformación de IA, la barrera más significativa para usar RAG es organizar y estructurar tus datos para que sean compatibles con un LLM.

Con una base en ingeniería de datos, la mayor parte del trabajo de implementación de RAG consiste en construir una fuente para una base de conocimientos adicional que exista dentro de tu organización y que esté alimentada por un conjunto de datos en vivo que se actualiza continuamente.

Dependiendo de tus objetivos, también podrías considerar crear múltiples fuentes de datos para usar en varias bases de conocimientos. Tener bases de conocimientos separadas para la información de productos y las directrices de la marca, por ejemplo, puede ayudarte a desbloquear nuevas aplicaciones para tu LLM habilitado con RAG.