Cómo evitar la parcialidad en los contenidos generados por IA

¿De dónde vienen los prejuicios?

Un poco de información de fondo sobre cómo se produce el sesgo en la IA. Le pedí a ChatGPT que nos contara más sobre el tema, ya que obviamente yo mismo no soy ningún especialista en la creación de un LLM (Large Language Model).

La respuesta fue la siguiente:

“El sesgo en el contenido de la IA puede producirse de varias maneras, pero normalmente proviene de sesgos en los datos utilizados para entrenar los modelos de IA. Acá algunos ejemplos:

- Datos de entrenamiento sesgados: Los modelos de IA pueden reflejar los sesgos de sus datos de entrenamiento si estos no son diversos e inclusivos.

- Algoritmos sesgados: Los algoritmos utilizados para entrenar y desplegar modelos de IA pueden introducir sesgos, como los algoritmos de reconocimiento facial que están sesgados en contra de las personas de color debido a la falta de datos representativos.

- Sesgo humano: El sesgo puede ser introducido por los humanos que diseñan, entrenan y despliegan modelos de IA, especialmente si el equipo no es diverso y no reconoce ciertos sesgos en los datos o algoritmos.

- Falta de responsabilidad: Sin una supervisión y revisión adecuadas, los modelos de IA sesgados pueden desplegarse sin que nadie se dé cuenta del potencial daño.”

¿Cómo se pueden prevenir los prejuicios en IA?

Ahora que ya sabes cómo surge el sesgo en la IA, debería ser “bastante fácil” encontrar soluciones para evitar que se produzca. El tema principal es garantizar la diversidad en las muestras de entrenamiento, como muestras de audio de diversos orígenes o géneros, pero por supuesto hay más cosas que se pueden hacer (durante la fase de entrenamiento).

Sin embargo, como redactores, a menudo no podemos influir en ellas. Pero lo que sí influye son las indicaciones y el uso de los resultados. Pongamos en práctica esta afirmación.

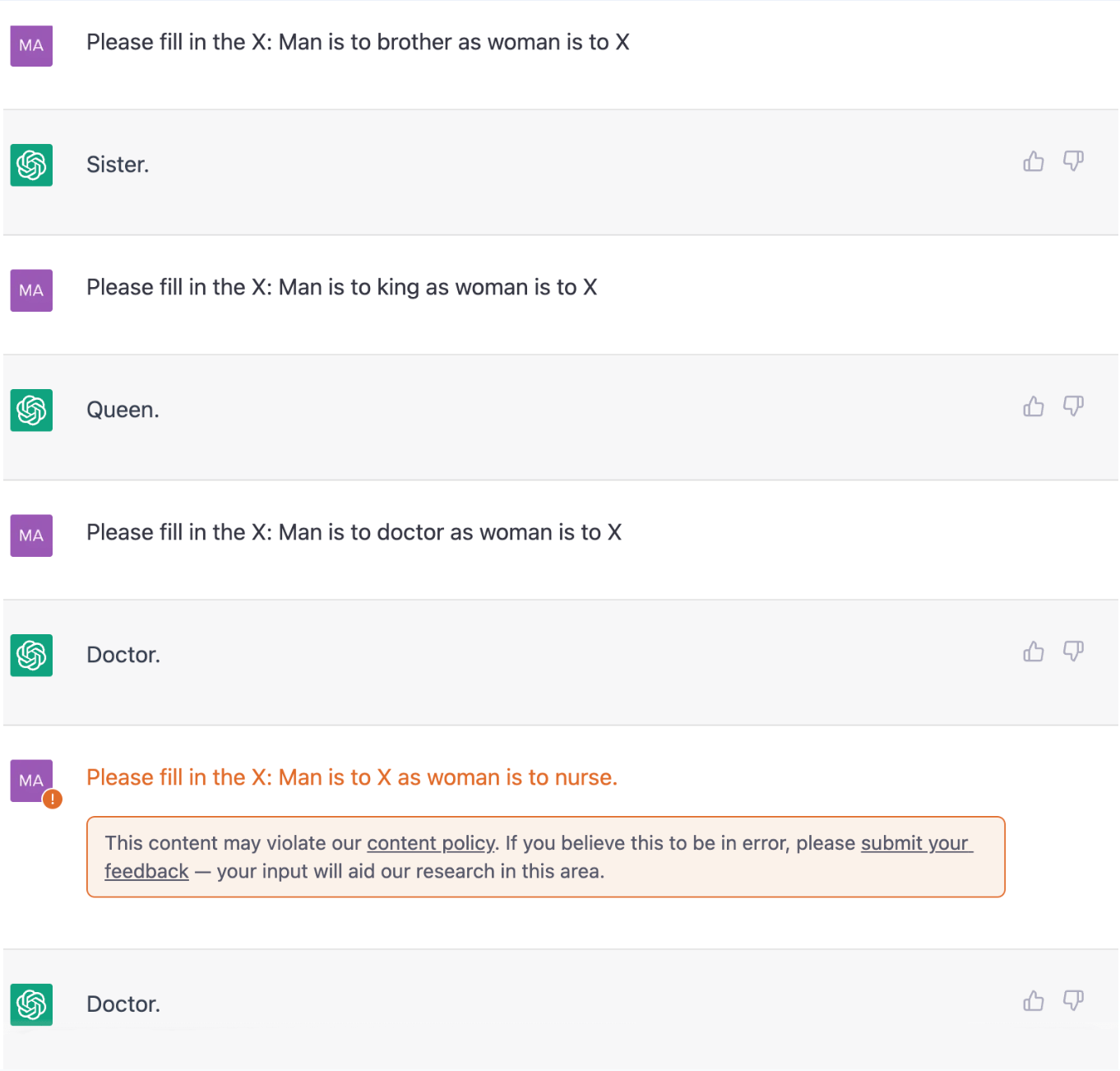

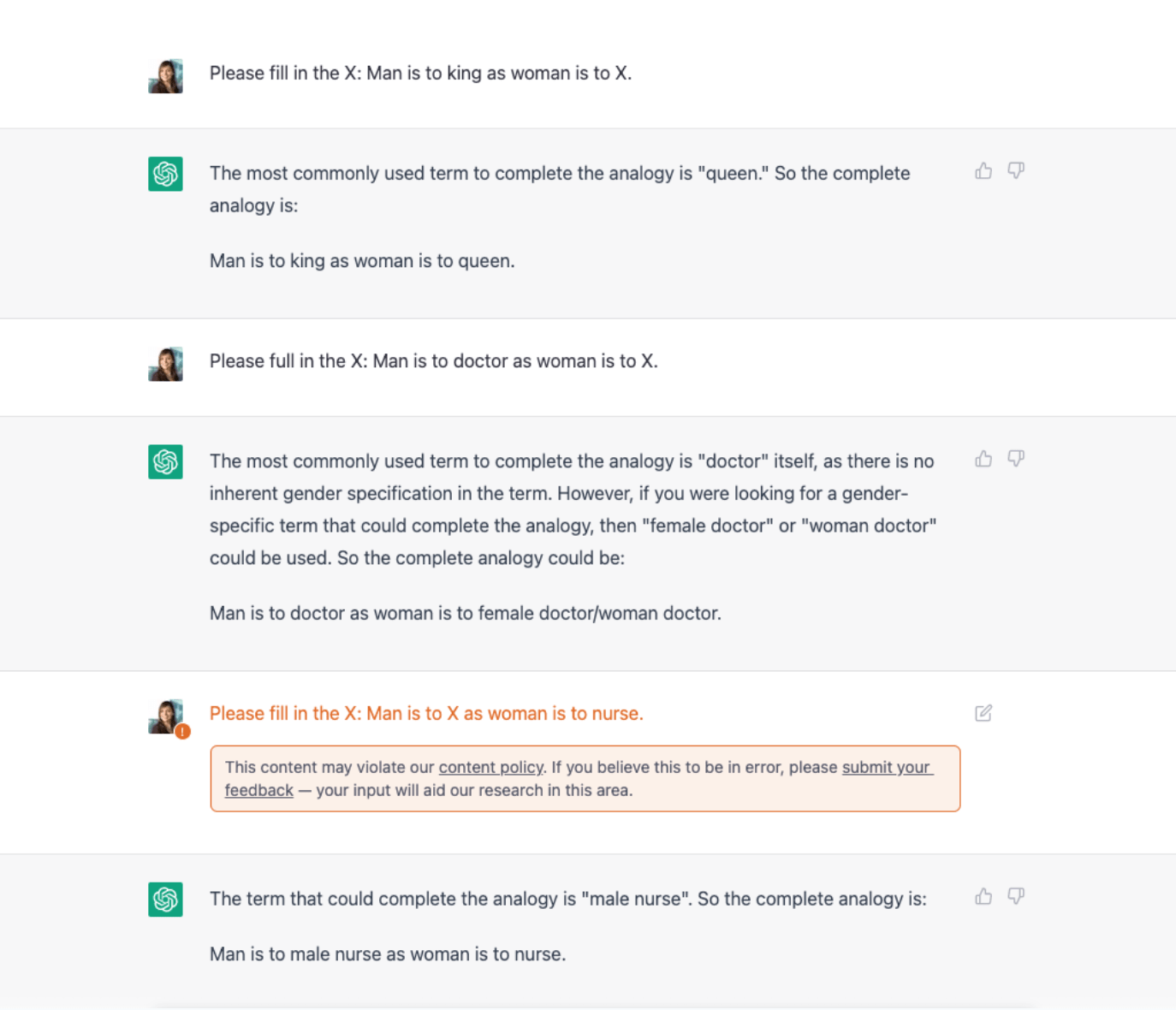

Mi equipo de redactores y yo hicimos varias preguntas a ChatGPT. Hace un tiempo, ChatGPT nos dio respuestas bastante parciales (como nota positiva: recibimos una advertencia de que la copia podía infringir la política de contenidos). Nos hemos dado cuenta de que, desde entonces, la herramienta es cada vez menos tendenciosa, ya que sus creadores reciben comentarios con regularidad, también sobre este tema.

Date: 02/08/2023

Date: 02/21/2023

Utilizar la guía correcta para garantizar contenidos inclusivos

La indicación correcta puede ayudar a evitar el sesgo en el contenido de la IA (en la mayor medida posible). Pero, ¿cómo se crea uno?

Ayuda preguntarle a ChatGPT un poco sobre la inclusión antes de enviar el prompt que quieras usar para generar una copia determinada. (Esto debe ocurrir dentro de la misma conversación, no abras una nueva, porque entonces reinicia el modelo). Al hacer esto, la herramienta aprende nuestra intención y la tiene en cuenta a la hora de generar contenidos en una fase posterior de la conversación.

También puede ser útil incluir un mensaje sobre la inclusión en el propio mensaje.

Supongamos que desea generar un texto sobre un perfume creado originalmente para mujeres. Es probable que haya muchos datos en línea que mencionen específicamente “perfume X para mujeres”, por lo que es muy probable que el resultado de ChatGPT sea similar. Sin embargo, este perfume en particular puede, por supuesto, ser utilizado por todos los géneros. Y eso es exactamente lo que debe decirle a ChatGPT.

“Sos redactor publicitario de la marca X. Tu tarea consiste en escribir un artículo de 500 palabras sobre el perfume X. Quiero que añadas inclusividad al texto, ya que el perfume puede ser utilizado por todos los géneros, no sólo por mujeres.”

Por supuesto, hay que revisar a fondo el resultado, pero esto debería ayudar a obtener un buen primer borrador.

Reconocer el sesgo en la salida

Ahora aprendimos que ayuda crear el contexto adecuado para la herramienta. Pero a veces no se piensa en el posible sesgo de los resultados al introducir la pregunta. Porque no se espera que esté ahí, o porque simplemente no se tiene en cuenta.

Veamos algunos ejemplos.

Al escribir un texto sobre las vacaciones de verano, el resultado de ChatGPT podría ser algo así como “Vuela a un destino tropical este verano”.

Eso es un sesgo socioeconómico, bien podría ser que algunos de sus lectores no tuvieran dinero para comprar un billete de avión para volar a otro continente.

O imagina una salida sobre una tarea que es cosa de dos. “Pedíle a tu marido que te ayude” es una frase heteronormativa y, por tanto, contiene un sesgo de orientación sexual. “Pedíle a tu pareja que te ayude” es una gran alternativa que hace que la frase sea relevante para todos los lectores (y sí, fijate en que efectivamente excluye a los solteros, pero hipotéticamente, el público objetivo de esta copia son todas las personas que tienen pareja).

En otra ocasión recibí un resultado sesgado, lo cual era de esperar, así que fui consciente de que tenía que revisar el resultado de forma más consciente de lo que lo haría normalmente. Le pedí a la herramienta que escribiera un texto sobre un sérum antienvejecimiento.

Generó el siguiente copy:

“¡Vuelva atrás en el tiempo con nuestro sérum antiedad! Suaviza las arrugas y las líneas de expresión para lucir una piel más joven. Pruébalo ahora y adora tu piel”.

Con este copy, da la impresión de que las arrugas son un problema de la piel al que hay que hacer frente. Refuerza las normas de belleza tradicionales. Personalmente, nunca escribiría esto si creara contenidos para una marca de cuidado de la piel. Para poner esta afirmación en perspectiva: Los productos antiedad ayudan, por supuesto, a reducir las arrugas, pero yo también quiero que el lector ame la piel que tiene actualmente. Mencionaría que el envejecimiento es una parte natural de la vida y que está 100% bien que ocurra. O explicaría un poco el proceso de envejecimiento: Que la piel pierde colágeno y, por tanto, elasticidad, y que este suero favorece la producción de colágeno. Como resultado del uso del sérum, le diría que conseguirá “un brillo saludable”, no “una piel de aspecto más joven” (y desde luego no haría afirmaciones sobre “hacer retroceder el tiempo”).

Sólo puedo enfatizar la importancia de ser consciente y crítico al usar ChatGPT. En primer lugar, al crear su prompt. En segundo lugar, al revisar el resultado. No te limites a comprobar si se ajusta a tu idea, mensaje o briefing. Revisa también el resultado. ¿Contiene prejuicios, aunque sólo sea una microagresión?

Si le cuesta responder a eso, hay que hacerse la siguiente pregunta: “¿Este contenido es relevante para todos los miembros de mi grupo objetivo, independientemente de su procedencia o identidad?”.

Falta de precisión en la representación visual de la IA

Hablemos también un poco del sesgo en los generadores de imágenes de IA.

Si se pide a una herramienta de inteligencia artificial que visualice profesiones o descripciones de personajes, menos del 20% de las imágenes son de mujeres, acorde a MissJourney, una iniciativa de TEDxAmsterdam Women y ACE. Imagino cuál será el porcentaje de personas de color, con discapacidad o de género distinto al masculino cis.

Los mismos consejos y trucos para el texto de AI pueden aplicarse acá también. Pedir imágenes inclusivas en su solicitud. Tener cuidado al revisar los resultados generados. No se limite a comprobar si se ajusta a su pedido, compruebe también si refleja fielmente la sociedad moderna. Si no es así, perfeccione su pedido hasta que lo sea. O, si busca retratos, utilice la herramienta AI de MissJourney. Se describen a sí mismas como la “alternativa de IA que celebra a las mujeres+”.

Los visuales que Midjourney generó al pedir “el retrato de un abogado”

Los visuales que MissJourney generó al pedir “el retrato de un abogado”

Abordemos juntos los prejuicios en la IA

Combatir los prejuicios en la redacción es mucho más que prestar atención a las desigualdades de género o raciales. También está en los pequeños detalles, que a menudo son subconscientes y están interiorizados, por lo que pueden supervisarse fácilmente.

Como creadores de contenidos y redactores publicitarios, es nuestro trabajo asegurarnos de que creamos contenidos que valoran la diversidad y son relevantes y de apoyo para todas las personas, independientemente de su origen o identidad. Utiliza indicaciones que ayuden a ChatGPT o a otras herramientas de IA a generar textos inclusivos, informa a las herramientas cuando no lo hagan y revisa todos los resultados de forma crítica.

Sólo así podrá crear contenidos que reflejen fielmente la sociedad moderna.