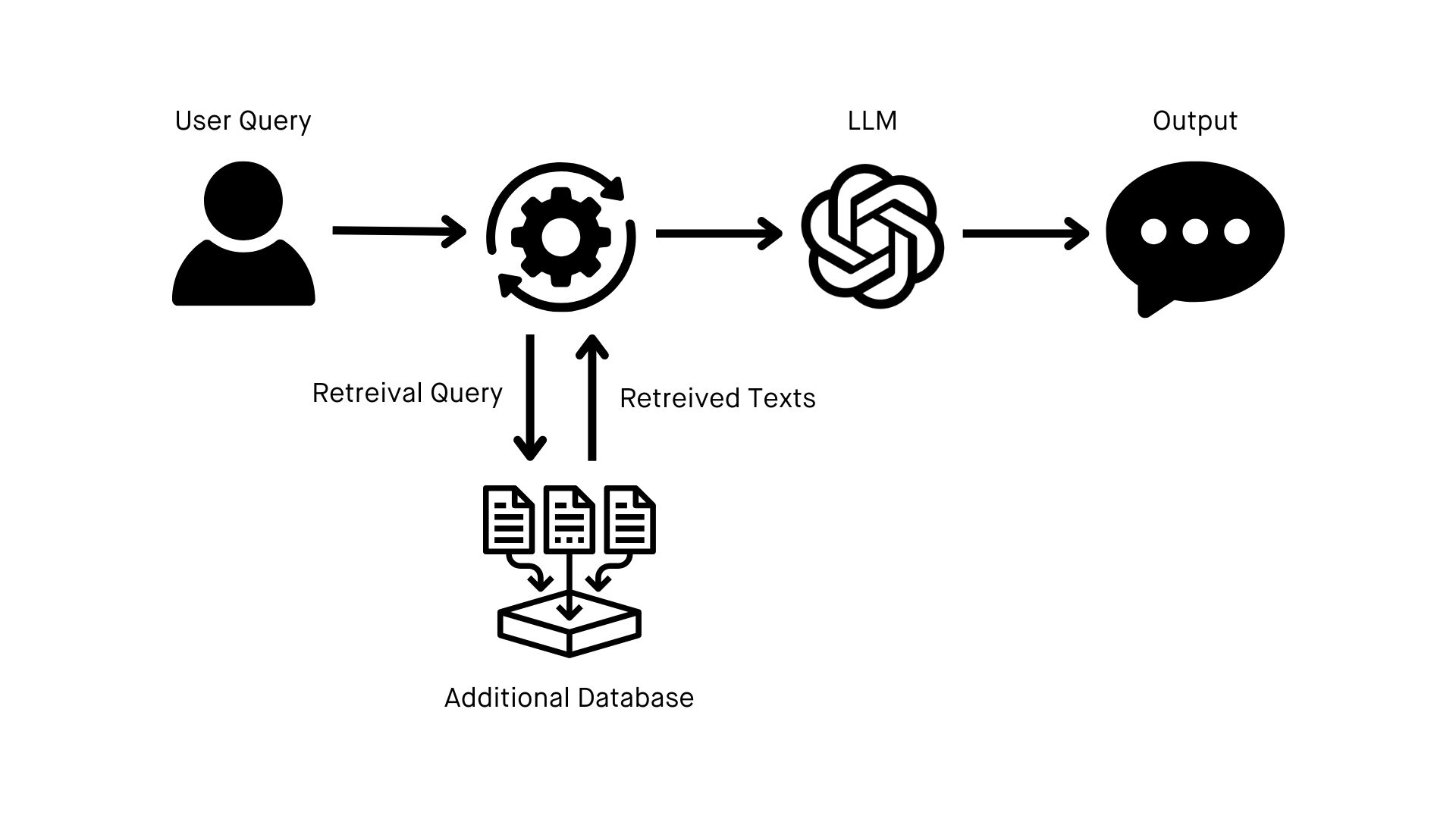

Um mit dem Aufbau Ihrer eigenen RAG-Implementierung zu beginnen, benötigen Sie drei Wesentliche Dinge.

Die Vorbereitung dieser wird je nach Komplexität Ihrer Daten und dem aktuellen Stand Ihrer Architektur mehrere Monate dauern. Die gute Nachricht ist jedoch, dass dies der zeitaufwändigste Teil des Prozesses ist. Sobald Ihre Ziele und Daten gut vorbereitet sind, dauert die eigentliche Implementierung von RAG und das Testen des Systems nur ein oder zwei Wochen.

Noch besser: Diese grundlegenden Elemente sind nicht nur entscheidende Schritte für RAG, sondern lassen sich auf praktisch jeden anderen Aspekt der KI-Transformation Ihres Unternehmens übertragen.

Eine Reihe klar definierter Ziele

Bei RAG gilt: Je spezifischer Sie angeben können, was Sie erreichen möchten, desto besser. Ob es um die Verbesserung des Kundensupports, die Erstellung personalisierter Inhalte oder die Verbesserung datengesteuerter Entscheidungsfindung geht – wenn Sie wissen, wann und wie Sie letztendlich mit dem System interagieren, erhalten Sie die Orientierung, die Sie für die Dauer des Implementierungsprozesses benötigen.

Das richtige LLM

Es mag offensichtlich erscheinen, aber Sie müssen das LLM auswählen, das für Ihren Anwendungsfall am besten geeignet ist und das in ein Abfragesystem integriert werden kann. Sie können ein Open-Source-LLM wie Mistral oder Llama oder eine kommerziell erhältliche Option wie ChatGPT auswählen.

Einige wichtige Faktoren, die Sie bei Ihrer Entscheidung berücksichtigen sollten, sind Skalierbarkeit, Integrationsfähigkeiten, Kosten und (natürlich) Ihre zuvor klar definierten Ziele.

Eine Data Engineering Grundlage

Die beste Herangehensweise an RAG besteht darin, es als eine Data Engineering Übung zu betrachten. Angesichts des aktuellen Stands der KI, da sich die meisten Organisationen in den frühen Phasen ihrer KI-Transformation befinden, besteht das größte Hindernis für die Verwendung von RAG darin, Ihre Daten so zu organisieren und zu strukturieren, dass sie mit einem LLM kompatibel sind.

Mit einer Grundlage im Data Engineering besteht der Großteil Ihrer RAG-Implementierungsarbeit darin, eine Quelle für eine zusätzliche Wissensbasis zu erstellen, die in Ihrer Organisation vorgelagert ist und mit einem Live-Datensatz gefüllt wird, der kontinuierlich aktualisiert wird.

Abhängig von Ihren Zielen möchten Sie möglicherweise auch die Erstellung mehrerer Datenquellen für die Verwendung in mehreren Wissensbasen in Betracht ziehen. Separate Wissensdatenbanken für Produktinformationen und Markenrichtlinien können Ihnen beispielsweise dabei helfen, neue Anwendungsmöglichkeiten für Ihr RAG-fähiges LLM freizuschalten.